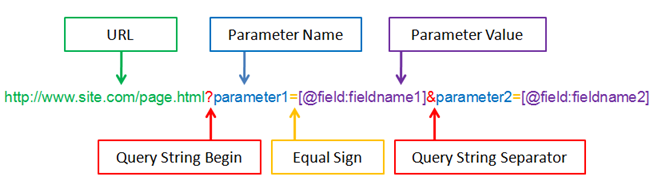

Analyse des paramètres d’URL pour les audits SEO

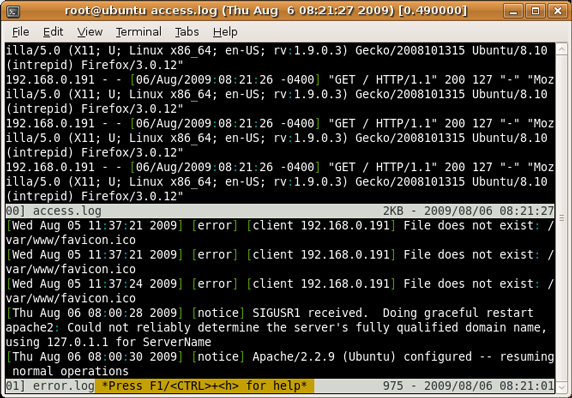

Les paramètres d’URL sont souvent la source de problématiques SEO. Parmi les éléments les plus impactant pour le référencement naturel, on peut citer : – la duplication de contenu– la mauvaise prise en compte des canonical– l’indexation (ou non) de… Continuer la lecture