Xenu est un excellent outil gratuit pour vérifier des liens mais aussi pour récupérer l’ensemble des balises <title> et <meta description…> de toutes les pages d’un site.

Xenu est un excellent outil gratuit pour vérifier des liens mais aussi pour récupérer l’ensemble des balises <title> et <meta description…> de toutes les pages d’un site.

En faisant un crawl d’un site pour un audit avec Xenu’s Link Sleuth, un petit bug a fait son apparition: la colonne<title>déraille dans certains cas.

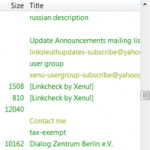

La colonne title de Xenu

La balise title, qui correspond (en général) au texte de lien dans les SERP’s, prend couramment cette forme dans vos pages: <title>Matt Cutts aime les chats</title>.

Mais d’après le W3C , elle peut aussi contenir des attributs HTML comme id (identifier la balise avec Javascript) ou dir (sens de la lecture du titre).

Lors du crawl d’un site, j’ai pu m’apercevoir qu’une page avec une balise TITLE contenant un id (<title id= »montitre »>Rankera bien qui rankera le dernier</title>) , la colonne correspondante de Xenu n’était pas renseignée. En effet, dès que Xenu trouve cette balise avec un ou plusieurs attributs, il n’extrait pas son contenu et la colonne se retrouve vide.

Xenu utilise un autre élément

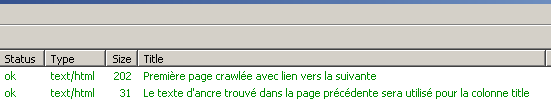

Malgré des attributs id, j’avais bien des infos concernant le titre mes pages pour certaines URL, mais qui ne correspondaient pas au contenu de mes <,title>: il va récupérer le texte d’ancre du lien permettant d’y accéder:

Je m’explique: Ma première page crawlée contient un lien vers la deuxième avec le texte d’ancre « Le texte d’ancre trouvé dans la page précédente sera utilisé pour la colonne title ». Ma deuxième page a une balise title avec des attributs: (<title id= »titre »>Ma page avec titre</title>.

Xenu affichera alors le texte d’ancre qui lui a permis d’aller trouver cette deuxième page. A noter que Xenu a ce comportement par défaut quand il trouve une balise <title> vide.

donc…

Xenu ne renvoit pas toujours la bonne balise TITLE des pages, il utilise dans certains cas (attributs dans la balise) les textes d’ancres des liens ce qui peut fausser les informations. Ne faites donc pas de recommandations SEO trop rapidement au sujet des titres de pages {pas|peu} optimisés lors de petits audits avec Xenu, les <title> ne sont pas forcément tous « cliquez ici » ou « plus d’infos ».

Salut Aymeric, c’est un peu comme pour les moteurs de stats, j’en utilise au moins 2 pour avoir une moyenne plus proche de la réalité.

C’est pareil lors d’un audit : j’utilise 2 tools pour obtenir une moyenne d’optimisation à préconiser ou non.

C’est certes plus long, le site audité risque d’en pâtir, mais au moins, lors de la remise de l’audit on donne des infos au plus prés de la réalité.

Sinon, pour en revenir à Xenu, j’ai remarqué un truc sur certain sites : lors du crawl des pages, il génère beaucoup de variable de session du type monsite . com/?PHPSESSID=cf1e1d97271e6ede249fee1ff19fa982 .

Pire parfois, ces pages se retrouvent indexées dans les SERPS : y a t il un lien de cause à effet, où alors mauvaise config du site en cause ?

Merci

Salut,

C’est une mauvaise configuration des sites, ils devraient avoir les identifiants de sessions dans des cookies. Cela doit générer d’ailleurs beaucoup de contenu dupliqué!

Salut,

cela génère du coup énormément de DC, en revanche je ne sais pas si ces URL dupliquées existaient avant ou après le passage de Xenu, ou s’il n’a fait que les révéler.

N’étant clairement pas un pure techos, aurais-tu une ressource à m’indiquer pour parer à cet écueil ?

Merci

D’un autre côté, Xenu n’est pas franchement le crawler idéal pour un audit SEO :p

Penchez-vous du côté du SEO Toolkit IIS qui peut fournir pas mal d’infos supplémentaires : http://www.witamine.com/2010/07/26/seo-toolkit-par-microsoft/

oui clairement;) mais parfois pour une vérification rapide sur les en-têtes, c’est pas mal de jeter un oeil au title par la même occasion. Merci pour ton lien, par contre Microsoft/IIS je ne sais pas trop…

J’ai aussi trouvé quelque disparité dans l’analyse de xenu surtout pour de l’analye de gros site (+ de 100 000 pages).

Par contre merci de l’info car ça peut être un gros inconvenient pour un audit seo.

Perso maintenant j’utilise « Screaming frog SEO » payant si on veux crawler plus de 500 pages mais très puissant en terme de filtre des crawls de page.

J’adore Screaming Frog SEO. Il permet de visualiser tant d’éléments comme les textes d’ancres vers chaque page, les Headings & co, un MUST have!

@Stone : stocke tes variables de session en cookies 😉

Sinon, merci de l’info, même si je pense pas qu’on croise tous les jours des webmasters qui mettent un id dans leur title. Si ? ^^

ça arrive, mais ça reste assez isolé je te l’accorde. Du coup, la petite vérification s’impose malgré tout;) Par contre, on peut croiser un peu plus souvent la directive dir= »ltr » ou dir = »rtl »…

Effectivement, xenu est pas mal, mais il est perfectible. J’ai déjà eu des soucis avec cet outil (je n’ai plus en mémoire précisément lesquels malheureusement).

Pour palier à ça, je fais soit une seconde analyse avec un outil différent, voir parfois une vérification manuelle de certains éléments qui me laissent septiques à l’issue de l’analyse.

Mais je ne prends jamais pour argent comptant ce que xenu m’indique.

@Mikiweb Il a l’air cool ce logiciel. Gros avantage, il est compatible Mac. Mais en revanche, que le logiciel soit payant, OK, mais de là à faire payer une licence annuelle, c’est un peu de l’abus… 100 euros par an pour un crawler, soit 1000€ sur 10 ans, ça commence à faire cher le crawler :/