♬ ♪ ♫Des petites liens, des petits liens, toujours des petits liens♬ ♪ ♫… La création de liens vous travaille en permanence, et bien moi aussi. Alors que j’étais en train de configurer une hôte virtuelle Apache avec des paramètres relatifs au Mod Headers, une idée m’est venue… Et si on mettait des liens dans les en-têtes HTTP, ça ferait quoi ? On va d’abord regarder si ça marche et si Apache ne filtre pas certains caractères comme > et <, après on verra comment en profiter 🙂

♬ ♪ ♫Des petites liens, des petits liens, toujours des petits liens♬ ♪ ♫… La création de liens vous travaille en permanence, et bien moi aussi. Alors que j’étais en train de configurer une hôte virtuelle Apache avec des paramètres relatifs au Mod Headers, une idée m’est venue… Et si on mettait des liens dans les en-têtes HTTP, ça ferait quoi ? On va d’abord regarder si ça marche et si Apache ne filtre pas certains caractères comme > et <, après on verra comment en profiter 🙂

Tuning d’Apache pour les BL

Il faut d’abord activer le module headers d’Apache, si ce n’est pas déjà fait: #a2enmod headers

Ensuite on va ajouter ces trois lignes dans notre fichier de configuration:

<IfModule mod_headers.c> Header set Superunbacklink "<a href=http://www.yapasdequoi.com>Un blog SEO comme un autre</a>" </IfModule>

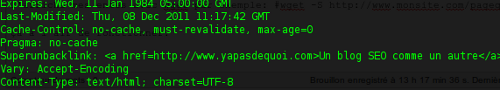

J’affiche mes en-têtes avec wget par exemple en appelant n’importe quelle page de mon site: #wget -S http://www.monsite.com/pagequiveutdesBL et ça à l’air de fonctionner:

Ranker sur ces drôles de liens

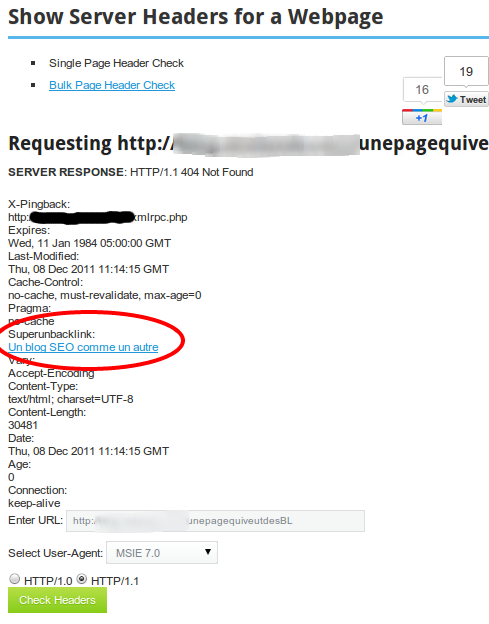

Mais comment tirer profit de ce lien maintenant? Pas mal de sites proposent des analyseurs d’en-têtes HTTP comme Web-Sniffer, afin de vérifier entre autre le « Status » (200, 302, 302, 404…) renvoyé pour une page Web donnée par le serveur qui la délivre. On pourrait alors vérifier les en-têtes HTTP de mon site qui rajoute le header Superunbacklink <a href=http://www.yapasdequoi.com>Un blog SEO comme un autre</a> et voir si mon lien s’affiche dans la page de résultat d’un de ces outils en ligne. Reste juste à en trouver un qui ne va pas filtrer le HTML.

Je teste les premiers proposés par Google comme Web-Sniffer, Webmaster-toolkit.com. Ils filtrent le HTML ou n’affichent que les en-têtes connues. Il faut persévérer et j’en trouve enfin en troisième page, youpee! (proposé par un site SEO héhé)

Dernière condition requise, que la page de résultats soit indexable donc vérifier le robots.txt et les balises meta. Dans le cas ci-dessus, il y a un <link rel=canonical, mais j’ai trouvé d’autres HTTP Headers checker qui marchaient, heureusement! Il ne me reste plus qu’à faire indexer cette page de résultats qui est en GET (ça tombe plutôt bien) et trouver un analyseur d’en-têtes HTTP sur un .edu (on peut rêver).

Il y avait le « Spam Referer », on pourrait appeler ça le « Spam HTTP Header ». Pour ceux qui douteraient de l’efficacité de cette technique, sachez que c’est surtout pour le fun comme j’en discutais avec @512banque, mais libre recours à votre imagination: on peut aller beaucoup plus loin…

Crédit Photo/source: Closermag (http://www.closermag.fr/content/54115/2011-sera-lannee-gainsbourg)

J’aime beaucoup le vice derrière cette idée !

Bravo :p

Tu es fou, mais c’est pour ça que je t’aime. Très bonne idée.

Tu vas mal tourné Aymeric ^^ ATTENTION 🙂

Excellente reflexion en tout cas.

Venant de ta part, je suis flatté 😉

Bonjour,

petite question, ça me parait fort bien intéressant tout ça mais si je pige bien la démarche faut obligatoirement faire ça avec un dédié non?

Il faut que tu puisse contrôler les headers d’apache. C’est peut être qqch de possible avec des .htaccess , à regarder.

Ensuite il faut voir si ton hébergeur (mutualisé donc) t’y autorise.

Plus clair ? 😉

martin à raison, c’est même une bonne idée de le faire ainsi :

via un .htaccess :

php_value auto_prepend_file modif_header.php

combiné à un rewritecond, c’est peut être la solution la plus efficace.

Non, tu n’as pas nécessairement besoin d’un dédié. Tu peux le faire via un .htaccess où le bon module Apache est installé (mod_headers). Si ce n’est pas le cas, tu peux toujours te rabattre sur un bout de code PHP (fonction header()).

Le hic qui se pose ici certainement est qu’on passe alors beaucoup de temps à chercher des pages indexables par les moteurs de recherche. Oh, certes, il y en a, ça fait de jolies fermes de contenus sur des sites spécialisés dans l’automatisation à outrance. Mais souhaite-t-on vraiment avoir des milliers de liens depuis ces sites là ? Car il y a d’autres petits malins qui en auront aussi, et cela fera un voisinage de liens assez médiocre, au final.

Bref, l’idée est très astucieuse, mais je crains qu’elle ne soit pas particulièrement intéressante pour du qualitatif. Ce serait vraiment spammer pour spammer. Oui, du « spam referrer », en effet…

Les liens ne seront pas de grande qualité c’est sûr (contenu page/ pas in-text), après ça reste toujours un lien… C’était juste une idée hein 😉

ahah bien vu.

Plutôt que passer par Apache, on peut aussi faire ça dans le code de la page et c’est plus simple à « tuner » dans ton exemple toutes les ressources de ton serveur ont ce header (img/js/css html etc..) c’est un peu bourrin.

En php ça donne :

<?php

header('Superunbacklink : Un blog SEO comme un autre ‘);

?>

code à ajouter tout en haut de page.

Oui, c’est clairement plus rapide et ça va permettre de varier les ancres + facilement. Je parlais d’Apache parce que c’est comme ça que l’idée m’est venue

Bien vu l’artiste ! Belle trouvaille, totalement dans l’esprit BH, j’adore…

Excellent ! Technique très créative 🙂

Très bon, il fallait y penser 🙂

Tu vires BH ? Petit filou, c’est très très bien ce que tu viens de nous pondre.

Tu peux ajouter autant de liens que tu veux ? Si oui, j’ai des idées… 😀

On pourrait imaginer pousser des en-têtes un peu plus complexes, libre recours à ton imagination 😉 Je ne vais pas vous mâcher le travail hein!

Bravo bonne idée

Ah ah, très bonne idée. 😀

C’est une idée qui viens tôt le matin ça non ?

Eh eh ! Très bon cette trouvaille ! Bien joué.

Eh bien il y en a qui on de l’imagination chapeau bas !!! , maintenant question il en dit quoi GooGle de ce genre de technique parce qu’il decortique les en-têtes HTTP lui ? merci d’avance pour la réponse des spécialistes SEO, vous en pensez quoi !

Mais ou vas tu chercher ce genre d’idées ! Tu ne doit pas beaucoup dormir tellement ton brain doit être dans une telle effervescence …. 😉

Très astucieux sur le principe et Bravo pour l’ingéniosité.

J’admire la curiosité, le raisonnement est bon mais au final le jeu en vaut il la chandelle parce que cela me semble compliqué tout cela juste pour un petit lien…

Je préviens tout de suite, moi je viens spammer.

Bon a part ça, c’est encore une bien bel astuce. Je me demande quelle est la vraie valeur de ce genre de lien, après tout on se retrouve parmi des milliers de pages avec très peu de jus. Par contre c’est pas mal pour signer ses sites en tant que créateur. Invisible et présent 🙂 Enfin comme tu dis, c’est pour le fun ^^

Par contre t’as testé de passer un robot Google avec GWT dessus pour voir ce qu’il te sortais ? Possible qu’il suive ton lien après tout et la ça devient beaucoup plus intéressant 🙂

@Le Juge: On peut aller plus loin je pense, je t’en parlerais de vive voix – et puis, un petit lien, c’est toujours un petit lien 🙂

c’était surtout pour l’esprit de l’astuce, après il faut réfléchir à d’autres concepts similaires (ou pas)…

@Didier: Merci =)

@paul, @BeTrash: Je suis pas BH dans l’esprit à priori. mais c’est vrai que là je commence à mettre un pied dedans avec ce genre d’idées ^^

@Magicyoyo: oui ça m’est venu le matin;)

@Seo Black Inside: LOL, non d’ailleurs je vais aller me recoucher, je suis crevé 😀 Merci pour ton commentaire!

Good spirit, bien joué t’es passé du coté obscure man! 😉

Wow, et bien ça c’est pas beau comme technique ça, mais j’adore, un peu comme avoir son lien de la part d’Alexa.com.

Bon ba à tester d’urgence et je vas de ce pas share l’article à un pote plus fan du lien crado que moi, mais à tester avec un petit scrapebox pour trouver les analyseurs non ?

Pas con !

Enorme, ton côté blackos is dans la place 🙂

je vais surement tester je te fais mes retours!

et alors ?

un dicton ne dit-il pas : « un lien vaut mieux que deux tu l’auras » ?

Effectivement c’est pas bête. Je vois pas pourquoi on ne pourrait pas y glisser du texte ? genre du contenu spiner 😀 Dans se cas la ca serait beaucoup plus intéressant.

chut….:)

oui alors là c’est obscur de chez obscur 🙂 on n’est pas dans le qualitatif c’est certain, mais c’est tentant 😉

Superbe idée, j’aime beaucoup. J’imagineque ca peut s’automatiser plus ou moins… Et à l’extrême permettre du xss !

Excellent !! Inclure du spin serait intéressant quand meme ! je vais ne parler à notre programmeur

Encore une technique de siou pour récupérer des liens moyennement propre. C’est pas très utile pour un MS, mais comme on le dit un lien est un lien (pour les splogs)

Reste plus qu’à faire tourner scrapebox pour trouver un bonne liste de sites exploitables 😉

Franchement c’est bien trouvé, je rejoindrai certains commentaires en disant que c’est un peu compliqué.

Une fois les sites trouvés avec imacro il doit y avoir moyen d’automatiser tout cela pour les prochains sites.

Faut quand même avoir l’esprit tordu. J’ai tenté de trouver des pages propres qui affichent les entêtes, mais rien de bien génial…

Bien vu, cela me semble être par ailleurs, une véritable faille de sécurité pour ces scripts…

Bonjour,

Quelle technique ! Je me demande toujours comment on peut être amené à imaginer de telles techniques BH.

Après, il faudrait voir si on peut ranker avec mais l’idée est bonne.

bonjour, je ne sais pas si l’impact sur le référencement est vraiment important mais en tout cas cette idée a le mérite d’avoir été trouvé. Par contre l’idéal serait d’automatiser le processus pour éviter de tout faire à la main mais cela me semble effectivement compliqué à réaliser.

Avec PHP, il est même possible de n’afficher ce « header » que pour les requêtes effectuées par les sites ou l’on veut voir s’afficher le lien (invisibles pour les moteurs de recherche).

Autre piste de réflexion : les « TXT record » dans les DNS …

Au premier abord, j’ai pensé assister à un Xème HTTP Header Injection, mais c’est très imaginatif.

Bravo!

Sympa comme technique , ça donne pas mal de petites idées 😀