Les paramètres d’URL sont souvent la source de problématiques SEO. Parmi les éléments les plus impactant pour le référencement naturel, on peut citer :

– la duplication de contenu

– la mauvaise prise en compte des canonical

– l’indexation (ou non) de pages peu pertinentes

– le crawl inutile

On pourrait détailler ces éléments dans des articles spécifiques pour chacun des points mentionnés, mais pour la reprise des articles sur « Y’a pas de quoi! », je me suis dit que j’allais être succinct et aller droit au but:)

Analyser les paramètres d’URL avec un script

Afin d’être plus efficace dans les audits techniques que je réalise, et en fonction de la typologie des sites (souvent des sites à forte volumétrie d’URL), j’avais besoin d’un script qui me permette d’analyser rapidement les différents paramètres d’URL crawlés par Google suite à une extraction des logs Googlebot, mais également les différentes combinaisons de paramètres, ex:

/mon-url.html?p=23&uid=22 ou encore /mon-url.html?source=newsletter&uid=34

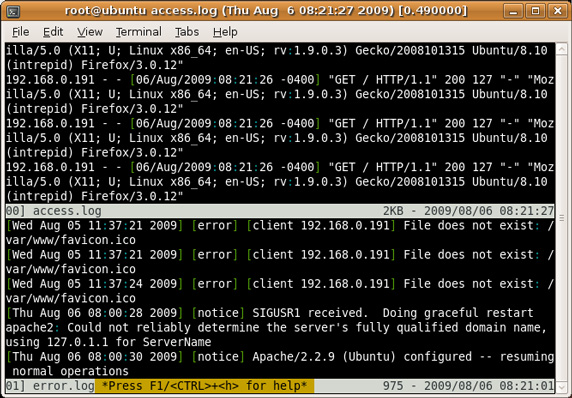

Je me suis tourné vers une commande existant dans toute console qui se respecte: AWK (« awk est une commande très puissante, c’est un langage de programmation a elle tout seule qui permet une recherche de chaînes et l’exécution d’actions sur les lignes sélectionnées. Elle est utile pour récupérer de l’information, générer des rapports, transformer des données entre autres. »)

L’objectif est d’obtenir à partir d’une longue liste d’URL issue des logs (on parle de plusieurs millions de lignes), le nombre d’URL correspondant à :

– chaque paramètre d’URL (ex: ?search=…)

– chaque combinaison de paramètres d’URL (ex: ?search=tournevis+cruciforme&session=6534229)

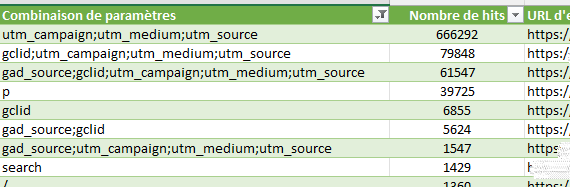

L’objectif étant d’arriver à un résultat comme celui-ci :

Cela permettra ensuite d’identifier les paramètres d’URL non pertinents crawlés par Google, afin de rediriger certaines URL, mettre en place des restrictions d’indexation pour limiter la duplication de contenu, ou encore bloquer certains paramètres via le fichier robots.txt. Vous pourrez également utiliser des segments dans Screaming Frog, et coupler tout cela à l’API de la Search Console, pour découvrir si des groupe d’URL avec certains paramètres sont visibles dans les SERP (à raison ou à tort)

Il ne faut pas oublier qu’à la suite de cela, on pourra également utiliser la Search Console pour découvrir l’origine de ces URL, et éventuellement corriger le problème à la source, afin d’éviter que les crawlers de Google ne découvrent des URL avec paramètres, qui pourraient ne pas être pertinentes dans le cadre de toute bonne stratégie SEO.

Script d’analyse de combinaisons d’URL

Il vous faudra donc en point de départ une liste d’URL dans un fichier texte. Voici le script à enregistrer sur votre ordinateur, qu’il faudra ensuite exécuter dans une console Linux/Unix :

#!/bin/bash

# On check si un argument (fichier) a été fourni

if [ "$#" -ne 1 ]; then

echo "Usage: $0 <file>"

exit 1

fi

# On éxécute la commande awk sur le fichier listant les URL du site, puis on trie les résultats

awk -F '?' '{

delete params;

if (NF > 1) {

n = split($2, paramArray, "&");

for (i = 1; i <= n; i++) {

split(paramArray[i], keyValue, "=");

params[i] = keyValue[1];

}

asort(params);

paramString = "";

for (i = 1; i <= n; i++) {

paramString = paramString (i > 1 ? ";" : "") params[i];

}

count[paramString]++;

if (count[paramString] == 1) {

exampleURL[paramString] = $0;

}

}

}

END {

for (comb in count) {

print count[comb] "|" comb "|" exampleURL[comb];

}

}' "$1" | sort -t '|' -k1,1nrUne fois enregistré, il sera nécessaire de rendre le script exécutable avec un :

#chmod +x analyse_params.shpuis lancer le script de la façon suivante :

./analyse_params.sh liste-urls.txtAnalyse des résultats

On pourra ensuite analyser les résultats et connaître les paramètres (ou combinaisons de paramètres) concernant le plus d’URLs, et en fonction de leur utilité/intérêt, envisager les actions à mettre en place afin que ces derniers ne soient pas nocifs à notre SEO!

PS: si vous êtes sous Windows, vous pouvez installer CYGWIN qui permet d’émuler une console Shell

Après avoir repéré et bloquer certains paramètres via le robots txt. Je constate que Googlebot n’en a rien faire.

Est-ce que dans ce cas, je devrais regarder pour obfusquer les source de mes urls paramétrées ?

C’est à dire qu’il ne respecte pas le robots.txt? Auriez-vous un exemple?